Resumo

- OpenAI lança uma atualização, GPT-4 Turbo, para corrigir o problema de “preguiça” do ChatGPT, principalmente no tratamento de tarefas de codificação.

- O ChatGPT conquistou 1,7 bilhão de usuários desde o seu lançamento, aumentando a eficiência e permitindo um trabalho de maior qualidade.

- A OpenAI também revela novos modelos de incorporação, text-embedding-3-small e text-embedding-3-large, para simplificar tarefas de aprendizado de máquina, como clustering e recuperação.

Com o ChatGPT e outras IAs generativas fazendo ondas, testamos seus limites. O ChatGPT parecia imparável, mas no final de novembro, os usuários observaram uma mudança peculiar no ChatGPT-4, com a IA parecendo “preguiçosa” e até sugerindo que os usuários realizassem as tarefas por conta própria. A OpenAI reconheceu o problema, mas não conseguiu identificar a causa. Agora, a empresa lançou uma atualização com uma possível solução para o problema.

O mais recente modelo de visualização do GPT-4 Turbo, derivado do GPT-4 mais amplamente disponível, treinado em informações recentes em abril de 2023, aborda o bug anterior (via The Verge). A correção visa conter casos de “preguiça”, em que o modelo não estava exercendo sua influência na conclusão de tarefas, conforme explicado em uma postagem no blog da empresa. Desde o lançamento do GPT-4 Turbo, vários usuários do ChatGPT notaram que o chatbot AI ficou um pouco frouxo, principalmente no manuseio de tarefas de codificação, em comparação com suas versões anteriores do GPT-4.

ChatGPT, a ferramenta ideal para quem prefere delegar tarefas no trabalho, ganhou 100 milhões de usuários ativos semanais em novembro de 2023 (via TechCrunch). A pesquisa indica que o ChatGPT desempenhou um papel no aumento da eficiência dos usuários, permitindo-lhes entregar um trabalho de maior qualidade.

No entanto, os usuários do ChatGPT ficaram em apuros quando a IA começou a jogar a carta do chefe, levando a OpenAI a intervir e investigar. No Reddit, os usuários estavam expressando suas queixas sobre a dificuldade de persuadir o ChatGPT a dar as respostas certas, experimentando diferentes prompts. Para muitos usuários, tentar fazer com que a IA funcionasse bem nas tarefas de codificação era uma verdadeira dor de cabeça, causando muitas reclamações.

A OpenAI não forneceu uma declaração sobre o motivo dessa mudança de comportamento, mas seus funcionários admitiram nas redes sociais que o problema é legítimo.

Em outras notícias do blog da OpenAI, uma nova versão do GPT-3.5 Turbo (gpt-3.5-turbo-0125) já foi lançada. A empresa diz que inclui “várias melhorias”, incluindo melhor precisão ao responder nos formatos solicitados e uma correção bacana para um bug que causa dores de cabeça na codificação de texto em chamadas de função em idiomas diferentes do inglês.

Além disso, a OpenAI está reduzindo os preços tanto da entrada quanto da saída do modelo. Os custos de entrada estão caindo 50%, para US$ 0,0005 por mil tokens recebidos. Enquanto isso, os custos de produção estão sofrendo um corte de 25%, agora em US$ 0,0015 por mil tokens emitidos.

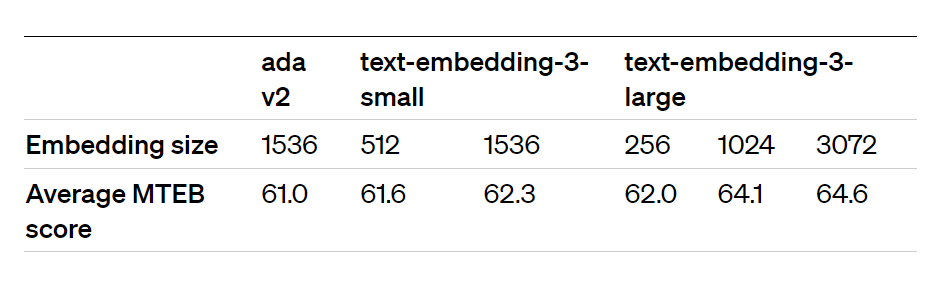

Um benchmark MTEB que demonstra a capacidade de reduzir o tamanho de uma incorporação text-embedding-3-large para 256, mantendo um desempenho superior a uma incorporação não encurtada text-embedding-ada-002 de 1536

Finalmente, a OpenAI revelou novos modelos de incorporação: text-embedding-3-small e text-embedding-3-large. Esses modelos transformam seu conteúdo em sequências numéricas, facilitando a vida de tarefas de aprendizado de máquina, como clustering e recuperação.