A linguagem humana é complicada. Compreender como os modelos de inteligência artificial (IA) dividem a linguagem em componentes digeríveis não é tão complexo quanto a linguagem. Ao aprender sobre IA, você poderá se deparar com o termo “tokenização”. Embora a tokenização pareça um jargão abstrato para gênios da tecnologia, não é difícil de entender, mesmo se você for novo nisso.

Esteja você interessado em criar programas de IA usando algo como GitHub ou queira entender como a IA funciona, aprenda sobre tokenização para aprofundar seu conhecimento sobre IA. A tokenização se aplica até mesmo ao uso de seus dispositivos Alexa favoritos e outros assistentes de IA. Veja o que é tokenização de IA, como funciona e por que é importante para modelos de aprendizagem de idiomas, como ChatGPT e outros aplicativos de IA.

Explicação da tokenização de IA em IA generativa

A tokenização é um método que os sistemas de IA usam para dividir a linguagem em partes menores. Os modelos de IA que lidam com linguagem, como chatbots, usam um modelo de linguagem grande (LLM). Esses modelos de IA possuem “tokens”, que representam uma palavra, caractere ou frase. Os humanos aprendem a dividir a linguagem nessas pequenas partes quando crianças. Por exemplo, aprendemos a pontuação básica antes de passarmos aos conceitos gramaticais. À medida que envelhecemos, não pensamos na linguagem como peças de um quebra-cabeça que se encaixam para formar um parágrafo ou frase, porque isso está arraigado.

O aprendizado de máquina deve dividir a linguagem nessas partes separadas para compreender as nuances da linguagem e do som mais humano. Os LLMs usam um processo matemático para compreender a linguagem, uma vez que não são humanos. Este conjunto de dados é o que diz ao ChatGPT e a outros modelos de processamento de linguagem natural (PNL) para criar frases que façam sentido.

Os sistemas de IA entendem e processam texto dividindo partes da linguagem em tokens. Ao usar um chatbot, por exemplo, você não vê nada acontecendo nos bastidores. O chatbot usa tokens para falar fluentemente e fornecer respostas que façam sentido linguisticamente. Tokens são as menores unidades de dados que os modelos de IA usam para gerar texto, de acordo com a empresa de design e desenvolvimento Povio.

Outra explicação sobre a tokenização vem da OpenAI, que desenvolveu o ChatGPT. Utiliza transformadores, o modelo de IA mais avançado. OpenAI afirma que “os modelos de IA aprendem a compreender as relações estatísticas entre esses tokens e se destacam na produção do próximo token em uma sequência de tokens”. Se um modelo de linguagem de IA compreender estatisticamente quais tokens (ou palavras, frases e pontuação) combinam, ele aprenderá a se destacar na produção de sequências de texto que façam sentido e melhorem com o tempo.

A tokenização não é apenas para chatbots. Também é usado em serviços de tradução de idiomas de IA, como Google Translate, mecanismos de pesquisa e software de reconhecimento de voz usados por modelos de IA, como Amazon Alexa ou Google Assistant.

Tipos de tokens de IA usados na tokenização

A linguagem tem diferentes partes, como pontuação, verbos e adjetivos. O mesmo acontece com o processamento de linguagem de IA. A tokenização geralmente envolve “subtokens”, que são diferentes tipos de tokens. Os subtokens podem incluir categorias como tokens de pontuação (reservados para pontos, vírgulas, dois pontos e outras marcas usadas no idioma) e tokens de palavras, que representam palavras inteiras. Por exemplo, pode haver um token para um ponto de exclamação ou um subtoken para a palavra “jornada”.

Algumas palavras podem ser divididas em partes (chamadas de tokenização de subpalavras), como a palavra “de repente”. Na tokenização, isso pode parecer “repentino” e “repentino”. Isso também pode ocorrer com palavras combinadas, mas que às vezes são entidades separadas, como “chatbot” que ocorre em dois tokens, “chat” e “bot”. Ou a palavra “namorado” torna-se “menino” e “amigo”.

O que são grandes modelos de linguagem?

Grandes modelos de linguagem (LLMs) são a base para chatbots de IA e muito mais. Aqui está o que está acontecendo nos bastidores

Há também um tipo de tokenização chamada tokenização morfológica, que divide as palavras em “morfemas”. Isso pega uma palavra e a divide em unidades menores e significativas. É comumente usado em idiomas que possuem muitos significados de raiz para palavras complexas.

Esses subtokens são partes da tokenização de IA que são geradas separadamente, mas se unem para formar parágrafos de texto totalmente detalhados.

Limitações de tokens em modelos de linguagem de IA

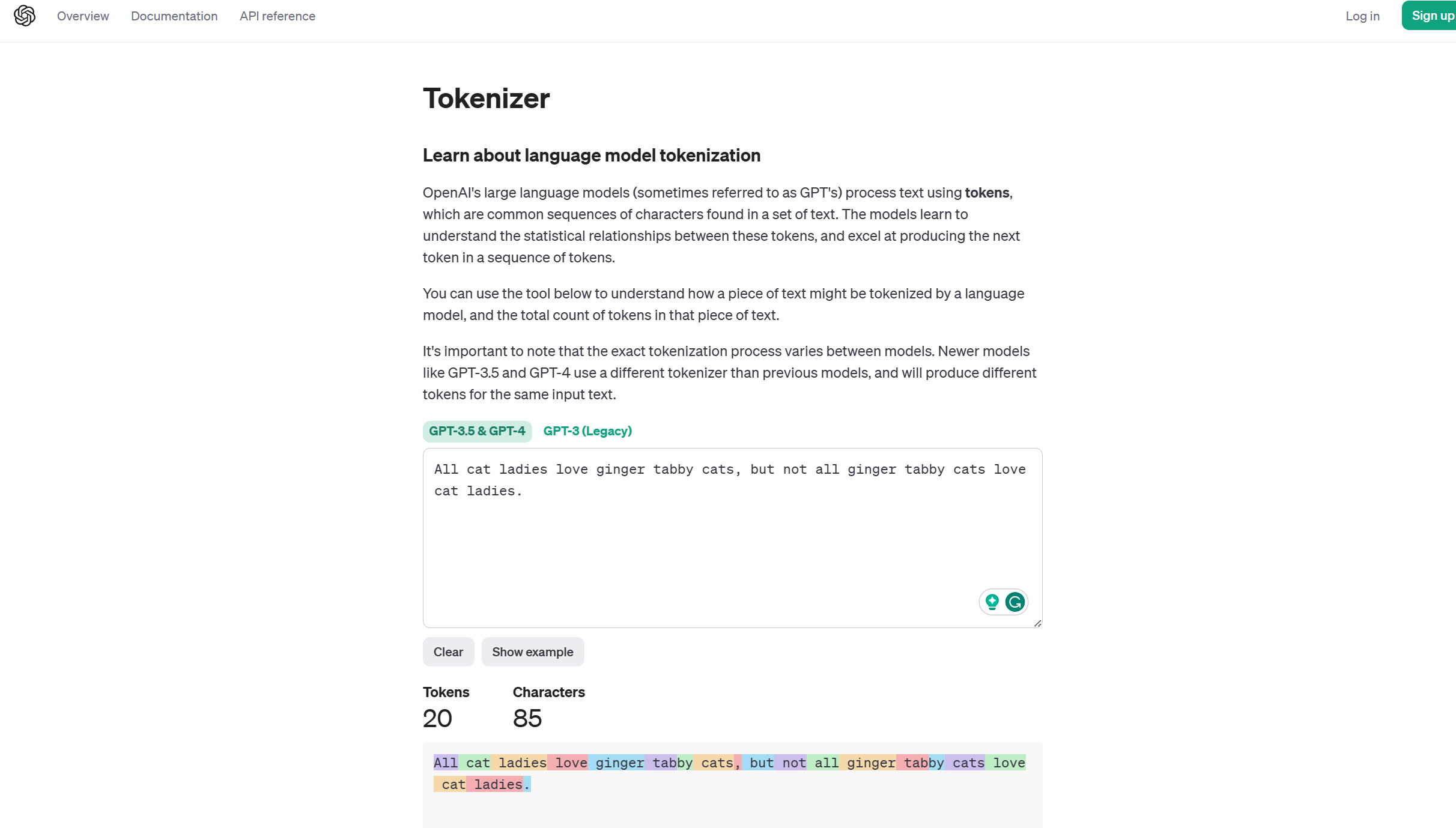

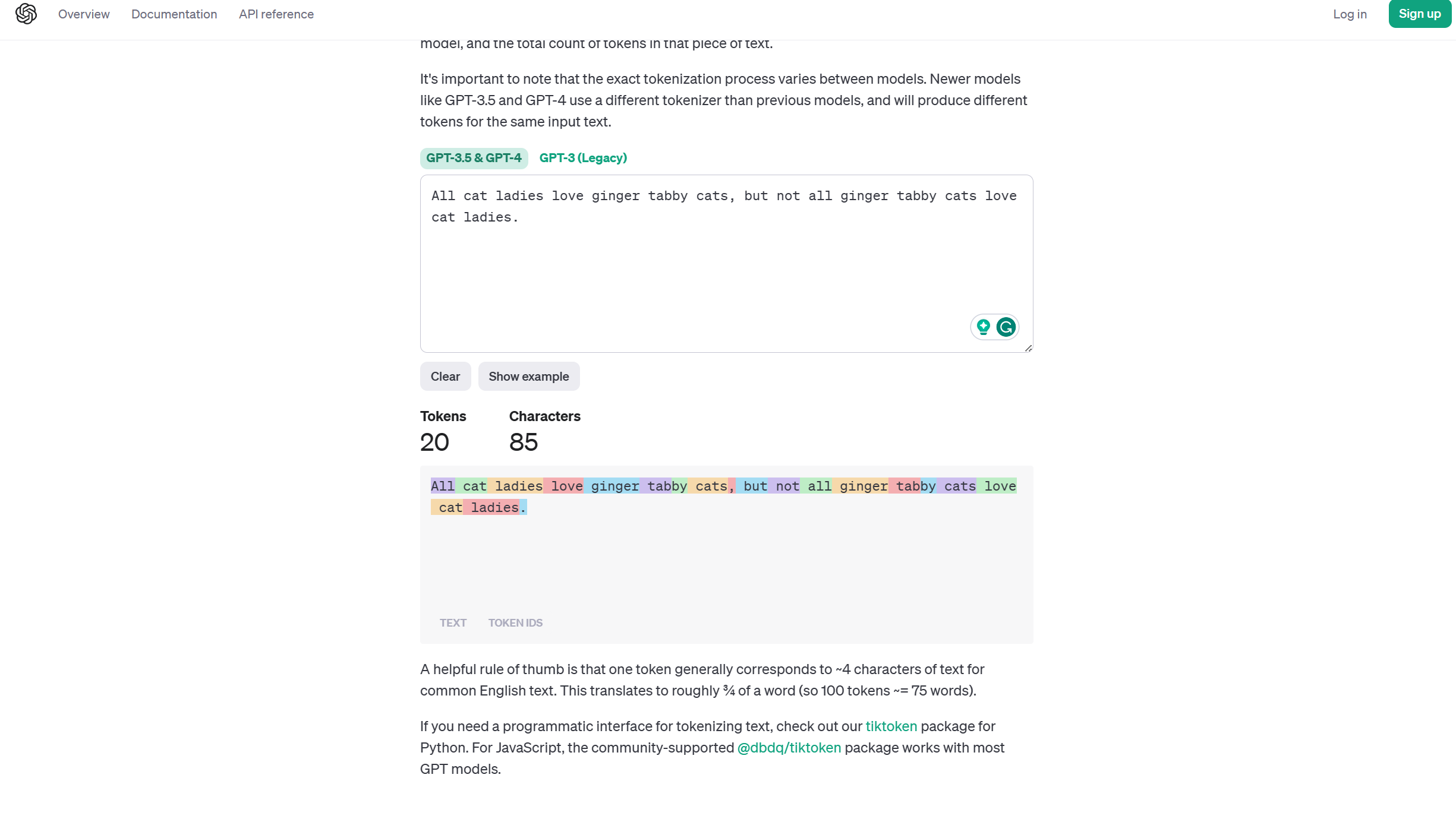

Certos modelos de linguagem de IA, como ChatGPT 3.5 e 4, têm um limite de tokens. O modelo de IA não pode ultrapassar um determinado limite de tokens gerados ao gerar texto e, portanto, gerar tokens. Para entender a aparência de uma frase de texto gerado em termos de número de tokens, use o Tokenizer da OpenAI gratuitamente. Digite qualquer texto e veja o que isso converte em tokens gerados por IA.

Por exemplo, digite: “Todas as gatas adoram gatos malhados ruivos, mas nem todos os gatos malhados ruivos adoram gatas”. No Tokenizer, os resultados mostram que esta frase continha 20 tokens. Quando você rola para baixo, ele também codifica palavras e pontuações diferentes por cores para ilustrar qual é um token separado.

Você pode não atingir o limite total de tokens no ChatGPT 3.5 ou ChatGPT 4. Ainda assim, é importante saber o limite ao inserir uma grande quantidade de texto. No ChatGpt 3.5, o limite é de cerca de 4.100 tokens. Há um limite maior para ChatGPT 4 de quase 8.200 tokens. Se uma frase de 16 palavras produz 20 tokens, há um aumento de cerca de 20% em tokens versus palavras. Esta é uma estimativa que não é infalível.

Seus tokens mudam dependendo da quantidade de pontuação usada e de outros fatores. Mas para fins ilustrativos, seu limite no ChatGPT 3.5 é de cerca de 3.280 palavras de texto para atingir 4.100 tokens.

A OpenAI também afirma em sua página Tokenizer que “um token geralmente corresponde a aproximadamente 4 caracteres de texto para texto comum em inglês”, o que significa que 100 tokens equivalem a 75 palavras.

Outros desafios na tokenização

Um grande modelo de linguagem usa aprendizado profundo para fornecer respostas do mundo real. O aprendizado profundo usa redes neurais profundas para processar dados e tomar decisões. Como a linguagem humana tem nuances, surgem alguns desafios na tokenização que os cientistas de dados não resolveram. Os dados de texto passam por pré-processamento. Conseqüentemente, o modelo de IA usa tokens para analisar e encadear frases.

O que é IA generativa?

Um agente da vontade humana, um amplificador da cognição humana. Descubra o poder da IA generativa

A análise de sentimento, por exemplo, é uma área dos chatbots de IA que poderia ser melhorada. A análise de sentimento é a combinação do modelo de IA de processamento de linguagem, linguística e análise de texto para determinar o “afeto” ou emoção da linguagem. Mas as emoções nem sempre são fáceis de compreender. Às vezes, um pedaço de texto pode ser interpretado como sarcástico. Outras vezes, pode parecer literal. Devido a essas ambigüidades na linguagem, a intenção por trás da saída do texto pode ser mal interpretada ou não ser o que a pessoa que fez a pergunta ao chatbot pretendia.

Outro problema ocorre em idiomas que não possuem espaços claramente designados entre as palavras. A tokenização é uma tarefa mais difícil ao analisar idiomas como chinês e japonês, pois nem sempre é claro onde as palavras começam e terminam.

Além disso, nem sempre é fácil lidar com caracteres especiais, como o símbolo “@” em endereços de e-mail ou barras, travessões e outros textos de URLs.

Como a tokenização pode melhorar os modelos de linguagem de IA no futuro

Os modelos de linguagem de IA são imperfeitos. No entanto, quanto mais os desenvolvedores trabalham na tokenização e tornam a IA mais consciente do contexto, é provável que o texto gerado melhore. A IA nem sempre fornece o texto que parece mais humano ou pode perder o ponto que você deseja atingir. Você terá que ser paciente com parte dessa progressão.

Você pode resolver o problema com suas próprias mãos e aprender mais sobre como a IA funciona para obter os melhores resultados. Você pode prestar atenção às penalidades de repetição da IA e como contorná-las. Você também pode aprender como aproveitar as respostas desejadas de modelos de IA como ChatGPT. Ser específico é melhor. Em vez de pedir a um modelo de IA um parágrafo sobre burros, peça um parágrafo de conversação sobre burros para um blog.

Seja específico, seja paciente e aproveite o passeio selvagem que é aprender sobre IA e o futuro da tecnologia. Enquanto você aprende, baixe os melhores aplicativos de IA para o seu telefone Android, porque é hora de acompanhar o tempo.