Quando os membros que partiram da OpenAI lançaram uma startup focada em IA, isso enviou ondas de choque por todo o Vale do Silício. Quando a empresa Anthropic revelou seu poderoso chatbot, Claude, essas ondas aumentaram. A empresa atraiu uma quantidade impressionante de capital de investimento, chegando a bilhões durante os primeiros dois anos. Claude pode não ser a contribuição mais significativa da Anthropic para a área. A empresa também é responsável por uma iniciativa menos chamativa, mas mais substantiva, chamada IA Constitucional. Alguns esperam que esta iniciativa molde o futuro da segurança da IA.

A IA tem lutado para encontrar uma posição relevante em dispositivos móveis, mas continua a fazer parte de nossas vidas, desde trabalhos de casa e pesquisas jurídicas até a criação dos melhores alto-falantes inteligentes. As restrições de segurança são uma preocupação crescente para desenvolvedores e consumidores. O que é IA Constitucional e por que é importante para o futuro da segurança da inteligência artificial?

A IA constitucional adere aos valores humanos

A IA constitucional é um conjunto de ferramentas e técnicas que garantem que a IA esteja estreitamente alinhada com os valores humanos, garantindo que seja útil, inofensiva e evite práticas enganosas. A Antrópica desenvolveu e registrou o conceito de IA Constitucional, e a empresa criou uma Constituição para grandes modelos de linguagem. Esta Constituição garante que IAs como Claude da Anthropic aderem aos valores humanos claramente definidos pelos autores da Constituição, em vez de aprender ou herdar valores durante o seu treinamento e evolução devido ao processamento de grandes quantidades de dados.

O que é antrópico?

Flash in the pan ou o futuro da inteligência artificial?

Como funciona a IA Constitucional?

Em um documento publicado no site da empresa chamado Claude’s Constitution, a Anthropic descreveu como definiu os valores da IA ao fazer com que os humanos selecionassem o melhor dos vários resultados da IA. Isso gerou preferências que a IA usou para influenciar resultados futuros, tornando o sistema mais preciso e útil.

Esta abordagem tinha várias deficiências e seria difícil de escalar à medida que a IA se tornasse mais complexa, rápida e sofisticada. Isso também significava que os manipuladores humanos frequentemente lidariam com resultados perturbadores da IA.

Para melhorar esse processo, a Anthropic transferiu o comportamento de monitoramento e regulação para a IA. A IA constitucional treina uma IA em vários princípios básicos sobre como evitar resultados tóxicos, prejudiciais ou discriminatórios, evitando ajudar as pessoas a se envolverem em atividades ilegais e concentrando-se no desenvolvimento de sistemas de IA que sejam éticos e úteis.

O modelo é apresentado a esses princípios orientadores e depois alimentado com exemplos. A IA tem a tarefa de analisar e refinar as suas respostas para se alinhar com os princípios constitucionais. Através da aprendizagem por reforço, onde a IA é recompensada pelos resultados apropriados e penalizada pelos resultados que violam esses princípios, a IA desenvolve uma política que molda o comportamento e as respostas futuras.

O futuro da IA Constitucional

A Antthropic afirmou que a principal razão pela qual a empresa foi fundada foi para realizar pesquisas de segurança em IA. A julgar pela ladainha de relatórios que a empresa publica continuamente em seu site, essa filosofia parece estar se sustentando. Algumas das pesquisas que eles estão conduzindo são extremamente interessantes e valiosas na prática.

O que são grandes modelos de linguagem?

Grandes modelos de linguagem (LLMs) são a base para chatbots de IA e muito mais. Aqui está o que está acontecendo nos bastidores

Um ótimo exemplo é um artigo da Anthropic publicado em outubro de 2023 detalhando os resultados de um experimento com IA Constitucional Coletiva. A Anthropic convidou cerca de 1.000 participantes para enviar ideias sobre o que deveria ser incluído em uma constituição de IA. Comparou os resultados da pesquisa com a constituição interna da empresa. Os pesquisadores então treinaram uma IA na Constituição Coletiva e compararam-na com os resultados do treinamento na constituição interna.

A constituição pública incluía algumas diferenças notáveis em relação à constituição interna da Anthropic, como uma ênfase no fornecimento de respostas que equilibrassem todos os lados de uma questão ou debate ou respostas que seriam mais acessíveis às pessoas com deficiência.

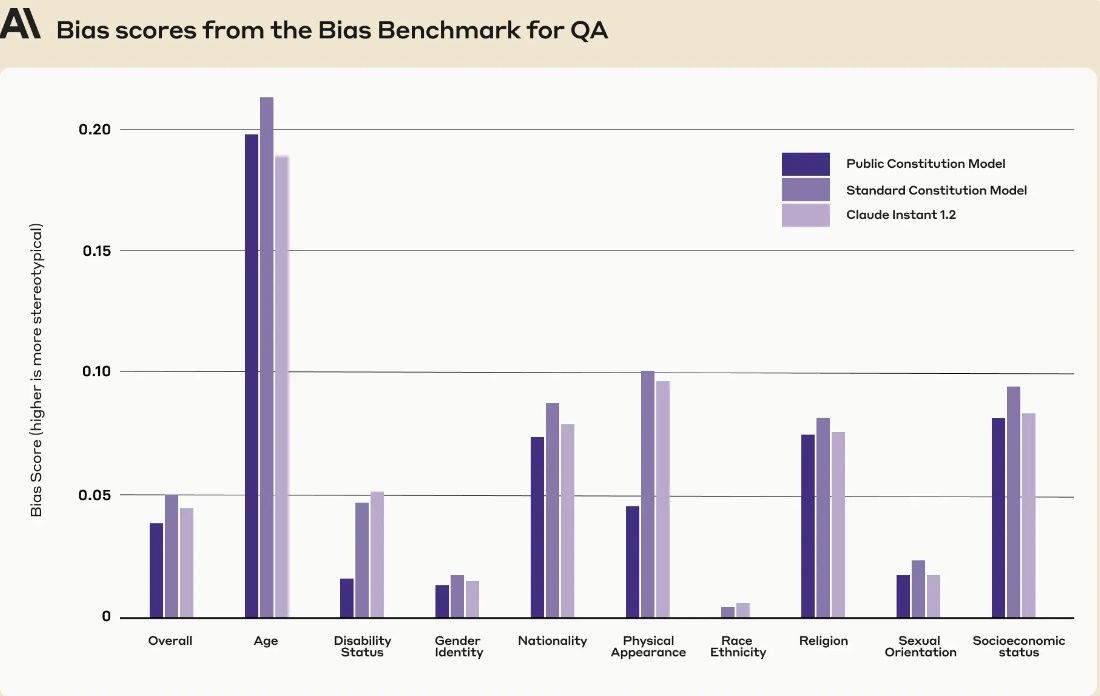

A Anthropic treinou dois de seus modelos menores de Claude Instant AI. Um sobre a Constituição Coletiva e outro sobre a sua constituição interna. Descobriu-se que os modelos tinham um desempenho semelhante em tarefas de compreensão matemática e linguística, partilhavam ideologias políticas semelhantes e eram tão úteis e inofensivos quanto uns aos outros. No entanto, o modelo formado pelo público exibiu menos preconceitos em nove dimensões sociais num parâmetro de referência de preconceitos, conforme ilustrado abaixo.

Fonte: Antrópico

Blefe ou farol?

O experimento da Constituição Coletiva demonstra o compromisso da Anthropic em explorar e refinar seus protocolos de segurança de IA. Ainda não se sabe se a IA Constitucional terá ampla adoção. Com pesos pesados como a Amazon e a Google a comprometerem milhares de milhões de dólares de investimento na visão da Anthropic, a empresa pode estar mais bem posicionada para estabelecer restrições de segurança universais para a inteligência artificial.

A segurança não é a única preocupação. A IA generativa tem alucinações e pode oferecer informações incorretas. Aprenda a identificar alucinações de IA e você não será enganado por dados falsos.