Resumo

- Gemini AI tem sido uma bagunça nas visões gerais da Pesquisa Google, com resultados imprecisos e perigosos aparecendo.

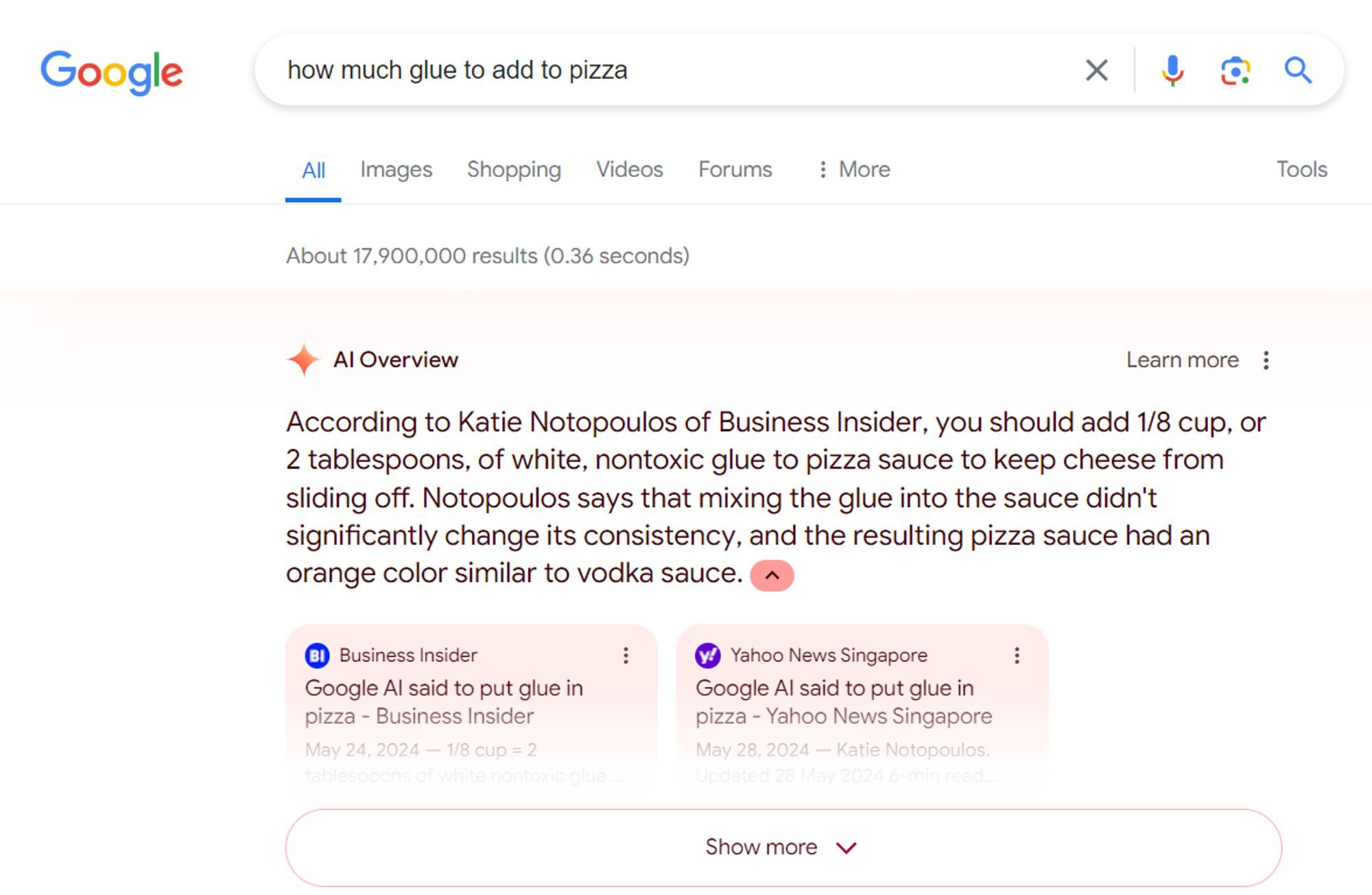

- As consultas dos usuários às vezes desencadeiam respostas absurdas, como adicionar cola à pizza, apesar dos esforços do Google para consertar isso.

- Mesmo com as tentativas do Google de restringir determinados conteúdos, as visões gerais da IA ainda podem mostrar informações imprecisas, como o infame incidente da cola de pizza que se repete à medida que a IA vê a cobertura noticiosa do primeiro incidente.

O Gemini do Google é uma família sólida de modelos de IA que alimentam quase todos os aspectos de IA dos telefones e aplicativos do Google, mas tem sido uma bagunça desde que começou a alimentar o recurso Visão Geral de IA para a Pesquisa Google.

O recurso, que estava em beta há meses, mas foi lançado pela primeira vez em maio, foi anunciado no Google I/O 2024. Sim, o evento onde a gigante da tecnologia disse “IA” mais de 120 vezes no palco. As visões gerais são essencialmente resumos concisos de informações que os usuários procuram, compactadas em um cartão de informações fácil de digerir. Uma semana depois, o Google anunciou que o recurso incluirá em breve anúncios patrocinados nas visões gerais de IA. Embora os usuários não tenham ficado particularmente satisfeitos com os anúncios na Visão geral, o inferno começou após um erro crasso subsequente.

O Google está no modo de controle de danos após o fiasco do AI Overviews

Alguns dos exemplos encontrados online foram ‘adulterados’, diz o Google

O recurso AI Overview começou a mostrar aos usuários resultados imprecisos e às vezes perigosos, como sugerir que os astronautas encontraram gatos na lua, aconselhar os usuários a comer pedras, sugerir aos usuários que adicionassem cola à pizza para garantir que o queijo grude bem, além de uma série de outros resultados que o Google disse mais tarde que poderia ter sido adulterado.

A gigante da tecnologia logo entrou no modo de controle de danos e removeu vários desses resultados imprecisos e perigosos. Posteriormente, publicou uma postagem no blog detalhando o incidente e o que deu errado. De acordo com o Google, o recurso de IA estava coletando informações para algumas consultas de usuários em artigos satíricos e comentários do Reddit, o que resultou em recomendações perigosas, como adicionar cola à pizza. A gigante da tecnologia acrescentou que agora desenvolveu mecanismos para detectar “consultas sem sentido” e que o recurso Visão Geral da IA não será acionado nesses casos. Além disso, restringiu a inclusão de conteúdo satírico e humorístico nas Panorâmicas.

Apesar das medidas, o Google ainda está preso no ciclo da cola para pizza

Fonte: Colin McMillen

Conforme descoberto por Colin McMillen, ex-funcionário do Google, a AI Overviews ainda fala sobre adicionar cola às pizzas. Quando questionado sobre “quanta cola adicionar à pizza”, o recurso de IA não repetiu seu antigo erro e, em vez disso, optou por procurar informações em locais confiáveis. A resposta correta aqui, como o recurso Visão Geral deve saber, é nenhuma. No entanto, um artigo recente falando sobre o erro inicial do Google com cola para pizza, cometido por Katie Notopoulos do Business Insider, onde ela realmente faz e testa uma pizza com 1/8 de xícara de cola não tóxica, foi escolhido pela Overviews. O recurso aderiu aos ajustes feitos recentemente e buscou informações “precisas” de uma fonte confiável.

Parece que a gigante da tecnologia está “tomando medidas rápidas” mais uma vez, já que não fomos capazes de recriar os resultados de McMillen. Até ontem, conforme confirmado pelo The Verge, os resultados obviamente perigosos ainda estavam em vigor.

Atualmente, as visões gerais de IA estão disponíveis apenas nos EUA (suspiro de alívio canadense). Se você estiver nos EUA, existem algumas maneiras que você pode usar para evitar ver as visões gerais da IA.

Como desativar o recurso Visão geral de IA do Google

Não existe uma maneira direta, mas você pode usar essas soluções alternativas para se livrar das visões gerais de IA dos resultados da pesquisa