É fácil ficar sobrecarregado pela enorme quantidade de anúncios no cenário da IA e é profundamente desafiador diferenciar o que é prático do que é irrelevante.

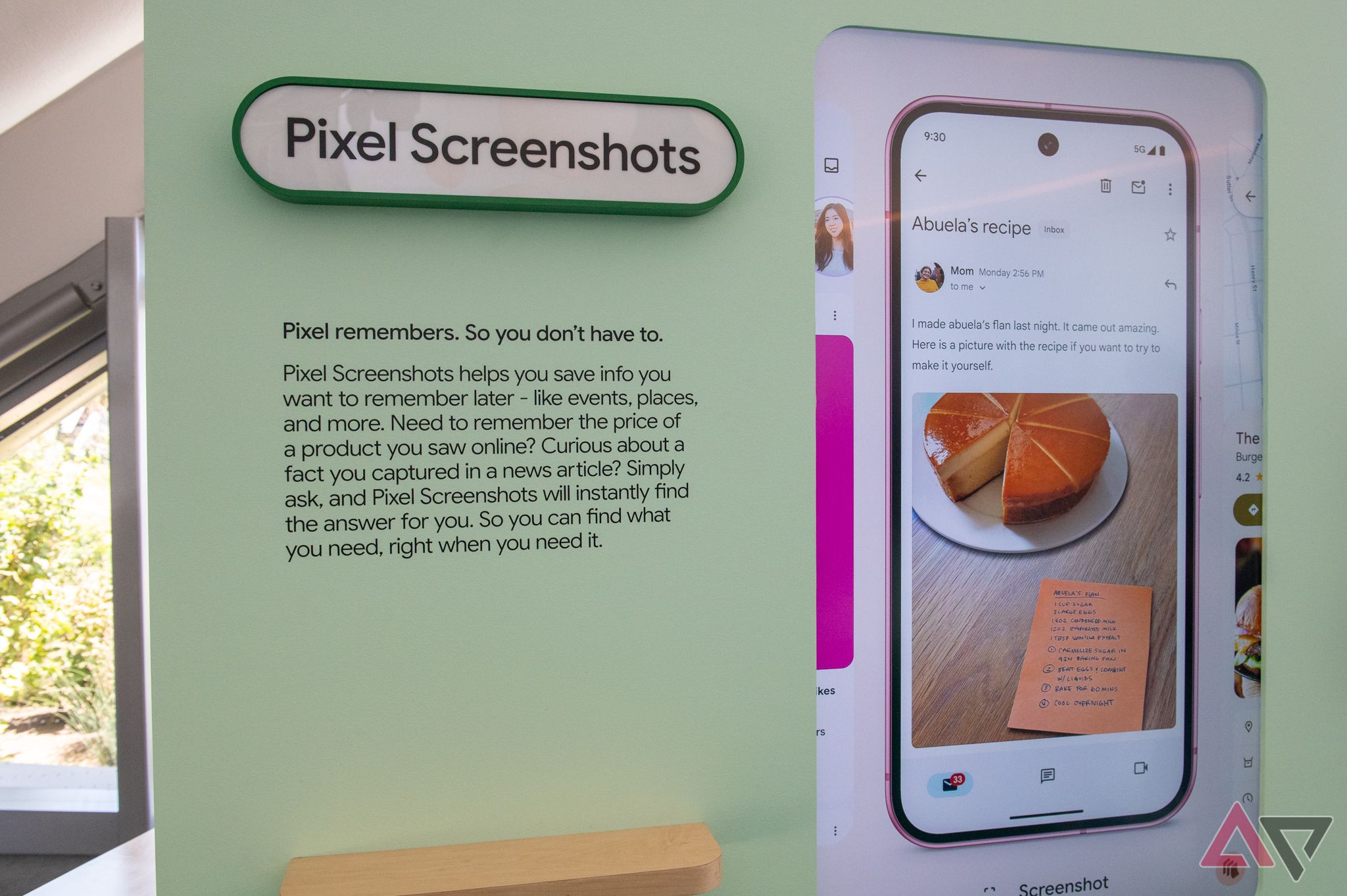

Embora a maior parte da atenção tenha sido dada a projetos maiores — conversas naturalizadas com vozes efervescentes e prestativas, ou geração de imagens que beiram o estranho — os projetos pequenos me interessam mais. No evento Made By Google desta semana, a empresa anunciou um aplicativo chamado Capturas de tela de pixel, um aplicativo pré-carregado (e, por enquanto, exclusivo) no Série Pixel 9. É alimentado por IA, mas daquela forma rara que combina precisão com ambição.

O problema que ele se esforça para resolver é tão antigo quanto o tempo: colocar ordem no caos; extrair o útil dos detritos digitais que coletamos diariamente. Eu sou o monstro que, por 15 anos, tentou e falhou em construir um sistema organizacional que funcionasse em projetos, plataformas e interesses. Eu criei uma aparência áspera e fragmentada de significado do Dropbox, Google Manter, Todoist, Airtable, Google Fotos, e um punhado de outros aplicativos e serviços que me mantêm, se não organizado, correndo em seu caminho paralelo.

Fonte: Google

Mas percebi que essas ferramentas são tão úteis quanto o esforço que você coloca para mantê-las, e conforme minha vida fica mais caótica, me vejo com menos tempo para cuidar desse pequeno pedaço de terra. Desejo mais empurrão e menos puxão; quero alguém, ou algo, para lidar com a extração de valor.

O Pixel Screenshots tem uma premissa simples: você provavelmente tira várias capturas de tela no seu telefone, muitas das quais são feitas para lembrar algo trivial ou importante, mas fundamentalmente valioso. Até agora, cabe a você lembrar de fazer algo com essas imagens. O Google Fotos nem faz backup de suas capturas de tela por padrão, pois elas tendem a ser consideradas desordem.

O aplicativo ingere todas essas imagens, os executa por meio de um filtro de IA local (nesse caso, o modelo de linguagem grande no dispositivo que é tão central para o sucesso contínuo do Google com a linha Pixel) e extrai o que ele acredita serem os pontos mais salientes: texto, datas e, mais importante, o que ele acha que você deve lembrar sobre isso. Em seguida, ele agrupa essas conclusões em coleções, às quais você pode adicionar manualmente ou filtrar, e exibe quaisquer datas relevantes para fácil análise no Google Agenda.

Percebi bem rápido que esse aplicativo se tornaria central para organizar o caos dos meus hábitos de navegação online depois de perceber que tenho usado o recurso “Favoritos” do próprio Google dentro do Chrome para selecionar manualmente meu próprio banco de dados de trechos da web, particularmente de receitas retornadas, por pelo menos meia década. O que começou como uma maneira simples de rapidamente agarrar receitas que meus filhos exigentes comeriam se tornou essencialmente meu banco de dados mais usado de insights sobre as maneiras subconscientes que meu cérebro tenta estruturar minha vida. Às vezes, me sinto tão perto da felicidade da organização que posso saboreá-la, mas sua natureza mercurial se encontra regularmente (e necessariamente) se redefinindo.

Percebi rapidamente que esse aplicativo se tornaria central para organizar o caos dos meus hábitos de navegação online

Passei um longo tempo conversando com Simon Walker, um dos responsáveis pelo aplicativo Pixel Screenshots, no evento de lançamento do Google na Califórnia esta semana, e fiquei ainda mais certo de que o futuro da IA não é o enorme projeto ambicioso que nos empurra desconfortavelmente em direção à IA, mas os pequenos projetos específicos inspirados no problema intratável de uma pessoa.

Onde vejo o potencial do Pixel Screenshots não é necessariamente em sua forma atual, tão limitada como é, mas em seu potencial como uma espécie de tecido conjuntivo passivo permeando a vida digital de alguém, uma versão evoluída do que empresas como Dropbox e Evernote tentaram realizar há mais de uma década. Enquanto essas empresas surgiram durante a era do desktop e construíram seus negócios em torno da redundância passiva de dados, no lado móvel, são realmente apenas os proprietários de plataformas, Apple e Google, que estão posicionados para oferecer a mesma experiência. Talvez o resultado final seja uma API ou um recurso integrado ao Chrome. De qualquer forma, é a capacidade da IA de extrair harmonia do caos que mais me interessa.

Também seria negligente se não reconhecesse que este domínio da plataforma tem aumento do escrutínio regulatório e antitruste para o Google e a Apple e é por isso que o DOJ pode recomendar que Android e Chrome serão alienados da empresa-mãe após obter uma vitória judicial histórica no início deste mês.

Mas a realidade é que o Google está na melhor posição para oferecer esse tipo de tecido conjuntivo pela internet, e por isso o Gemini, por mais exagerado que seja, está finalmente dando frutos de maneiras pequenas, mas significativas. Os sistemas operacionais móveis — até mesmo o Android, por mais aberto que seja — não incentivam a mesma manipulação de sistemas de arquivos e hierarquias de diretórios que suas contrapartes de desktop, e é por isso que serviços como o Google Fotos se tornaram inextricavelmente ligados às nossas identidades online. O Google Fotos, em particular, evoluiu muito além de sua competência inicial como um repositório de fotos baseado em nuvem, e hoje seu recurso mais importante é o memory roundup que infunde dados com nostalgia. Claro, o Google pode estar na melhor posição para oferecer esse tipo de tecido conjuntivo apenas porque pode forçar a internet a se curvar à sua vontade.

O Pixel Screenshots vê o Google construindo sobre o sucesso dessa evolução do Photos ao lidar com essa questão perene do colapso de contexto. As fotos, arquivos e outros destroços que salvo em minhas várias telas, e em particular no meu telefone, perdem o significado rapidamente e, embora a solução do Google não seja total — você ainda precisará adicionar notas aos itens mais importantes, por exemplo; sua integração do primeiro dia com o Gemini torna fácil ver por que a IA é tão boa neste caso de uso específico.

Ver o Pixel Screenshots em uso e, mais importante, conversar com a equipe por trás do aplicativo, proporcionou o momento de iluminação que muitas pessoas tiveram com Bate-papoGPT ou Midjourney há alguns anos. O Pixel Screenshots em si pode não ser a resposta para meus problemas — sejamos honestos, com o histórico do Google, ele pode não estar aqui em alguns anos — mas a maneira como ele funciona para concentrar o poder particular de descoberta e resumo da IA é galvanizadora.

O fato de ter demorado tanto para chegar aqui pode dizer algo sobre o quão peculiarmente meu cérebro funciona, mas conversei com céticos de IA o suficiente para saber que não estou sozinho nesse miasma de confusão e que geralmente são esses pequenos momentos que levam a grandes mudanças de comportamento.