Resumo

- Os modelos básicos de IA da Apple foram treinados nas TPUs de nuvem do Google, o que pode sugerir a preferência da Apple por hardware superior.

- A entrada tardia da Apple na tecnologia de IA fez com que ela pudesse alugar ou adquirir o hardware avançado do Google, demonstrando uma jogada estratégica no setor de tecnologia.

- O uso das TPUs do Google pela Apple seria irrelevante para os usuários finais, mas indica disposição de deixar de lado rivalidades para promover desenvolvimentos de IA, com o Apple Intelligence já lançado em dispositivos selecionados.

Em uma corrida para criar os melhores serviços de IA e chatbots, os nomes mais proeminentes em tecnologia buscam o hardware de computação em nuvem mais poderoso e eficiente para processar LLMs. Esse equipamento pode ser caro de adquirir, e a NVIDIA é uma fornecedora líder, mas em uma escolha interessante, a Apple parece ter usado as Tensor Processing Units (TPUs) do Google para treinar os primeiros modelos fundamentais para sua IA chamada Apple Intelligence. Alguém poderia interpretar isso como um aceno tácito ao hardware superior do Google, mas há mais do que aparenta.

Relacionado

O que são TPUs do Google Cloud?

O Google está mirando no setor de criação de IA baseado em nuvem: os TPUs do Google Cloud estão ajudando a vencer

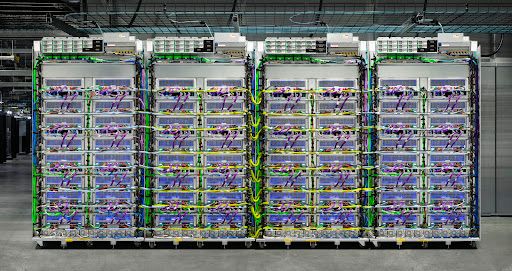

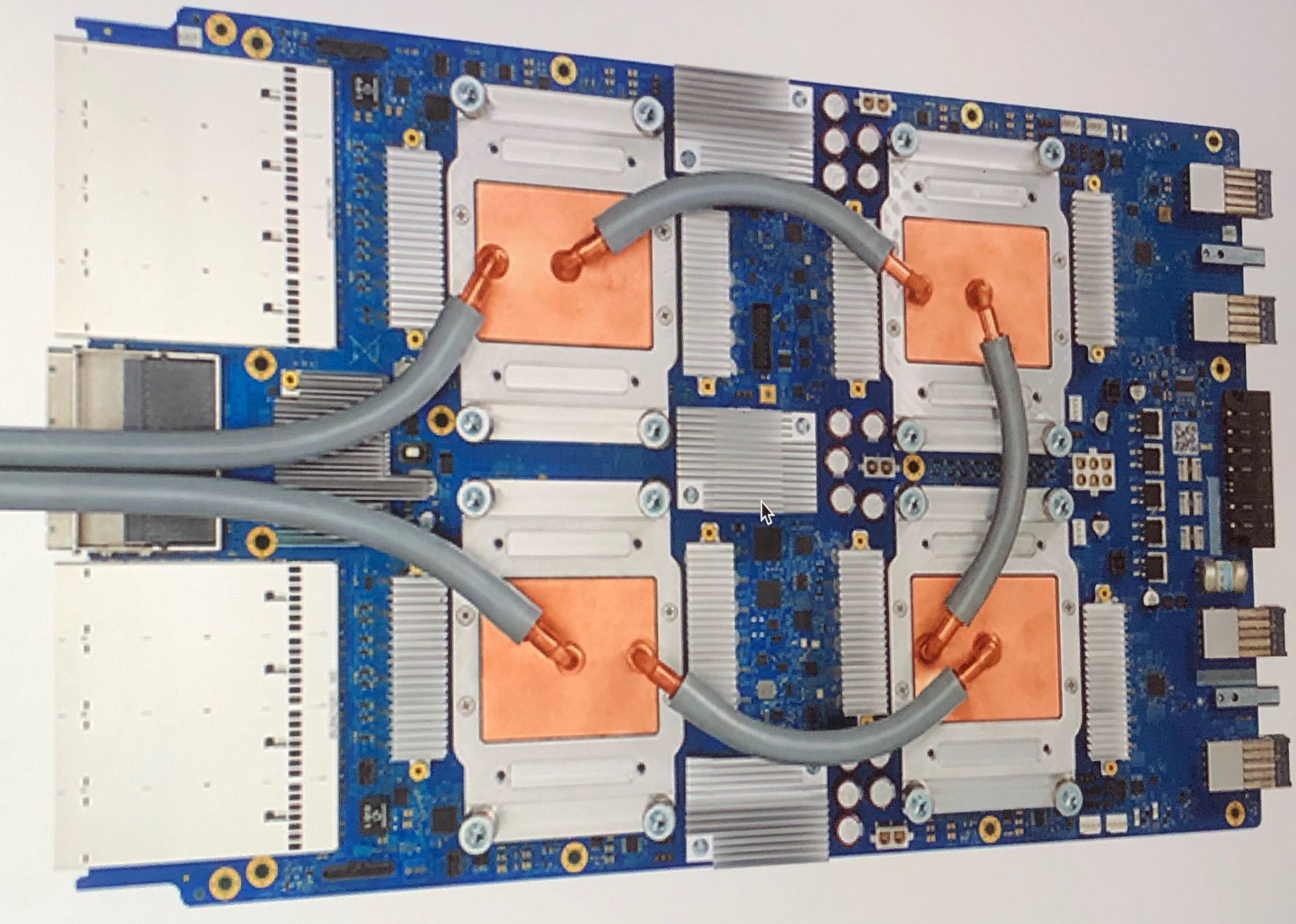

Para não serem confundidos com os chips Tensor série G que alimentam a linha de telefones Pixel do Google, os TPUs são hardwares desenvolvidos para esse propósito (Application-Specific Integrated Circuits) usados em data centers do Google desde 2015 e em público desde 2017, rivalizando com as GPUS da Nvidia preferidas para processamento LLM. A CNBC relata que a Apple lançou um artigo de pesquisa técnica de 47 páginas recentemente, discutindo os modelos de linguagem da Apple Intelligence Foundation.

Enquanto empresas como Microsoft, OpenAI e Anthropic não hesitam em discutir sua dependência de GPUs Nvidia, o documento da Apple revela que a empresa se afastou da norma, preferindo “clusters Cloud TPU v4 e v5p”. Especificamente, o artigo de pesquisa parece dizer que a Apple alugou clusters Cloud TPU para o trabalho pesado, para treinar Apple Foundation Models para implantação no dispositivo e no servidor. O modelo no dispositivo foi supostamente treinado nos últimos chips TPU v5p do Google lançados em dezembro.

O que isso significa para o Google?

A Apple escolher alugar o hardware de processamento de IA mais avançado disponível no momento não é uma coisa ruim, mesmo que os chips sejam fornecidos pelo Google. Isso porque a empresa sediada em Cupertino está elegantemente atrasada para anunciar qualquer interesse em tecnologia de IA, enquanto a maioria das outras empresas tem sido bastante vocal sobre seus pesados investimentos nela desde que a OpenAI popularizou o ChatGPT em 2022. O AppleInsider especula que o fabricante do iPhone pode ter comprado o hardware Tensor para usar localmente em seus próprios data centers em vez de alugar o hardware hospedado pelo Google. Afinal, o tratamento de consultas humanas pela IA importaria mais do que o hardware de computação subjacente a longo prazo.

A Apple e o Google não responderam ao pedido de comentário da CNBC sobre o assunto, mas a maioria das especulações relacionadas sugere que os esforços de IA da Apple virão à tona em breve, à medida que os investimentos continuam aumentando. Por enquanto, ela lançou o Apple Intelligence para um punhado de dispositivos em 29 de julho nas compilações beta para desenvolvedores do iOS 18.1 e macOS Sequoia 15.1.