A maior e mais recente tendência em tecnologia é a IA, e ela está em toda parte. A IA está se tornando cada vez mais relevante na vida cotidiana, desde novas versões de tecnologia existente, como os melhores telefones Samsung, até novos serviços como ChatGPT. Mas nem tudo são boas notícias. Existem várias questões sobre quão éticos, justos e precisos são os modelos de IA. Os pesquisadores de Stanford desenvolveram um método para avaliar modelos de IA para fornecer melhor transparência em torno de cada modelo e como ele funciona em diversas situações.

O que é o Galaxy AI, o que ele pode fazer e como posso usá-lo?

Saiba mais sobre o Galaxy AI e como usá-lo em seu telefone Samsung Galaxy S24

Avaliação holística de modelos de linguagem de Stanford: uma breve introdução

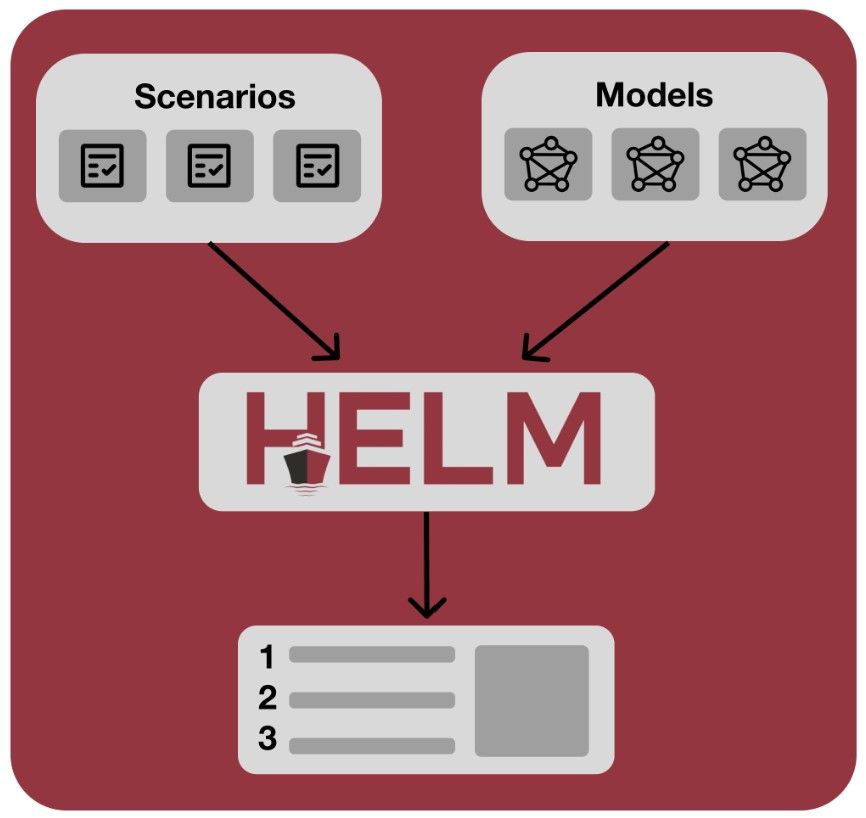

A Avaliação Holística de Modelos de Linguagem de Stanford (HELM) foi desenvolvida por uma equipe de 50 pesquisadores do Centro de Pesquisa em Modelos Fundamentais da Standard University. LEME consiste em três elementos principais:

- Ampla cobertura e reconhecimento de incompletude: teste tantos cenários quanto possível, mas reconheça que não é possível testar todos os cenários e indique quais deles não estão sendo avaliados.

- Medição multimétrica: Avalie modelos de IA em diferentes métricas que testam a adequação do modelo.

- estandardização: Padronize uma maneira de testar modelos de IA em estados semelhantes, tanto quanto possível.

Fonte: Centro Stanford para Pesquisa em Modelos Fundamentais

Um valor fundamental da equipe por trás do HELM é a transparência. O site do Helm disponibiliza os cenários, previsões, prompts e código do modelo para qualquer pessoa ver e revisar. O HELM fornece uma maneira padrão de avaliar modelos de linguagem e testá-los entre si para fornecer uma referência padrão do setor. Os pesquisadores pretendem continuar executando e refinando o HELM à medida que os modelos de IA progridem. A pesquisa é financiada pelo Google, entre outros.

Quais foram as descobertas iniciais do HELM?

Em 2022, os pesquisadores do HELM publicaram um artigo após a primeira versão de seu modelo ter executado mais de 4.900 avaliações de 30 modelos, totalizando mais de 12 bilhões de solicitações de tokens para esses modelos. Houve cinco conclusões principais deste artigo:

- Usar feedback humano para ajustar modelos de IA, chamado ajuste de instrução, é uma forma eficaz de treinar modelos e ajuda modelos menores a competir com modelos maiores.

- Modelos de IA fechados e limitados (como os da Microsoft e OpenAI) superam os modelos de IA abertos (como os da Meta).

- A precisão, robustez e justiça dos modelos de IA estão intimamente correlacionadas em situações normais. A precisão diminui quando menos precisos gramaticalmente ou outros dialetos do inglês são usados.

- A forma como um modelo é solicitado tem um efeito significativo em como o modelo responde. Este ponto demonstra a necessidade de uma padronização rigorosa na avaliação destes modelos.

- Há necessidade de melhores conjuntos de dados de resumo para treinar modelos de IA. Os modelos são bons em resumir de acordo com os humanos, mas os humanos avaliam os conjuntos de dados usados para treiná-los de forma menos positiva. Alguns modelos são bons na criação de manchetes sobre desinformação, mas não funcionam bem quando tentam incitar alguém a fazer algo com base em desinformação. Isto deve ser continuamente avaliado.

O que vem a seguir para HELM?

O que é tokenização de IA?

Compreender a linguagem da IA pode levar algum tempo, mas a tokenização não é tão complicada quanto parece

Após este artigo inicial, muito trabalho ainda está sendo feito no HELM. Existem algumas conclusões e próximos passos que foram descritos neste artigo inicial:

- Os pesquisadores gostariam de ter acesso a mais modelos de IA e mais informações sobre como os modelos são treinados. Isso ajudará a atingir seu objetivo de transparência.

- Os modelos ficarão melhores com o tempo. É imperativo continuar a refinar o processo de avaliação e testar continuamente modelos novos e refinados.

- Possui um site com as últimas descobertas e testes do HELM, este artigo que oferece mais detalhes e um repositório GitHub com o código HELM que pode ser usado para pesquisas futuras.

A transparência na IA é importante

A IA está abrindo caminho em mais facetas de nossas vidas. Para garantir que seja usado com segurança, precisamos avaliá-lo constantemente e tomar as medidas necessárias para torná-lo melhor para todos. Uma maneira de fazer isso é criar modelos de IA de código aberto, como o Mistral AI, para que os usuários tenham uma melhor visão dos modelos que estão usando.