Na semana passada, o Google estreou o Gemini 2.0. A nova família de modelos de IA que alimentam o chatbot de mesmo nome do Google vem com novos recursos, como a capacidade de acessar diretamente informações de serviços como a Pesquisa Google e criar nativamente imagens e áudio para incluir em suas respostas. O Google afirma que seus modelos recentes de IA foram desenvolvidos para a “nova era da agência” em que estamos entrando, na qual a IA pode acessar a Internet e usar ferramentas para realizar tarefas para os usuários.

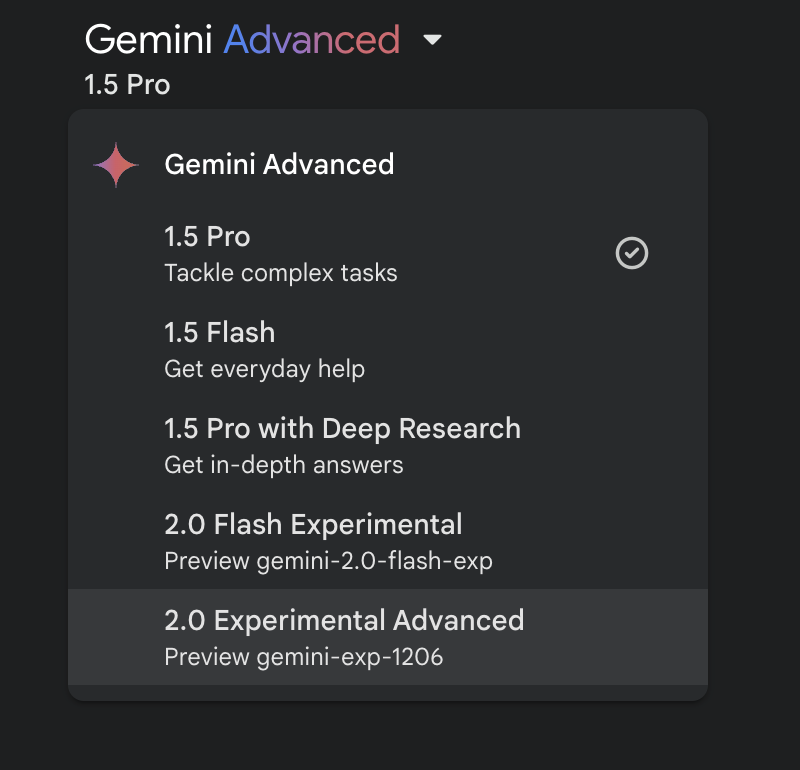

A partir desta semana, os assinantes do Gemini Advanced terão acesso para experimentar vários novos modelos: Gemini 2.0 Flash Experimental, Gemini 2.0 Experimental Advanced e Gemini 1.5 Pro com Deep Research. Estes se juntam às opções existentes do padrão 1.5 Pro (para “tarefas complexas”) e 1.5 Flash (para “ajuda diária”). Verifica-se que os assinantes pagantes teriam a oportunidade de experimentar novos recursos antecipadamente. Mas para um produto que deveria eliminar parte do trabalho de processos intrincados, como pesquisas aprofundadas e, eventualmente, tarefas de alto risco, como reservas de viagens, o Gemini está se tornando cada vez mais difícil de entender e usar.

Bem-vindo ao Compilador,

seu resumo semanal dos acontecimentos do Google. Passo meus dias como Editor do Google lendo e escrevendo sobre o que o Google está fazendo no Android, Pixel e muito mais, e resumindo aqui nesta coluna. Esta é a notícia do Google que você precisa entender esta semana.

Um modelo para cada tarefa

Os assinantes do Gemini Advanced agora têm um total de cinco modelos Gemini para escolher. Cargas de trabalho mais complexas consomem mais recursos, portanto, faz sentido empregar modelos diferentes para tarefas diferentes. Se um modelo Flash mais simples puder responder a uma determinada consulta tão bem quanto um modelo Pro mais complexo, executá-lo por meio do Flash em vez do Pro economizará um pouco de poder de computação – uma preocupação crescente no espaço de IA.

Mas um menu suspenso que permite aos usuários escolher manualmente entre cinco modelos diferentes para cada consulta parece uma maneira muito obtusa de gerenciar os vários recursos do Gemini. Aprendendo os meandros dos modelos com nomes como 1,5 Flash e 1.5 Pro com pesquisa profunda parece uma grande pergunta.

O Gemini 1.5 Pro com Deep Research, por exemplo, é o único dos cinco que pode realizar a função Deep Research do Gemini, que coleta informações de dezenas ou até centenas de fontes para criar relatórios detalhados. Gemini 2.0 Advanced, o modelo mais novo e geralmente melhor, ainda não consegue fazer isso. Se você pedir, isso servirá algo, mas não permitirá que você saiba que sua consulta seria mais adequada para 1.5 com Deep Research.

A IA não deveria simplificar nossas vidas?

O apelo das interfaces de IA em linguagem natural, teoricamente, é que você não precisa saber como elas funcionam para usá-las. Ao contrário de um aplicativo mais tradicional, onde você precisa aprender as nuances da UI e onde encontrar várias funções para realizar tarefas complicadas, com algo como Gemini ou ChatGPT, você não deve precisar de conhecimento especializado – apenas um conhecimento razoavelmente bem formado. consulta. Camadas em um menu de modelos abstratos para escolher para cada entrada (esta consulta é uma ajuda diária ou uma tarefa complexa?) parece estar em desacordo com uma das características mais valiosas deste tipo de aplicação: a acessibilidade.

A opção de escolher manualmente por qual modelo sua consulta será executada é uma vantagem sensata para assinantes avançados, mas não deve ser um requisito. Para facilitar o uso do Gemini, gostaria de ver uma versão futura que decida qual modelo é mais adequado para sua consulta automaticamente, sem supervisão manual. Do jeito que está, o Gemini nem mesmo avisa se você usou o modelo errado para uma determinada tarefa. A IA não deveria simplificar nossas vidas?

O Google Keep está prestes a brilhar?

O Android 16 Developer Preview 2 traz uma mudança interessante: torna o Google Keep um aplicativo de sistema, o que significa que você não pode desinstalá-lo sem acesso root. À primeira vista, isso pode parecer mais inconveniente do que qualquer outra coisa, mas provavelmente significa que o Google tem grandes planos para seu aplicativo de anotações, incluindo integrações mais profundas do sistema – a capacidade de iniciar o aplicativo a partir da tela de bloqueio em telefones Pixel, por exemplo.

Estou animado com a possibilidade. Há anos que uso o Keep para anotações rápidas por conveniência, mas nunca gostei muito dele. Comparado com outros aplicativos que usei para fazer anotações – Evernote, Obsidian, Apple Notes – o Keep sempre pareceu um pouco básico. Você pode pesquisar suas notas e adicionar rótulos, mas não há uma categorização robusta; você não pode criar pastas, e o aplicativo ainda se apega ao seu conceito original de notas representadas como cartões no estilo de notas adesivas.

Mas se o Keep se tornar um foco maior para o Google, adquirindo recursos como pastas, alguma categorização de IA com tecnologia Gemini e talvez um bloco de configurações rápidas para abrir uma nova nota no Android como o Apple Notes tem no iOS, posso me ver usando-o porque eu quero, e não apenas porque é o aplicativo de anotações que instalei.

Enquanto isso…

O gerador de vídeo Veo 2 do Google parece extremamente impressionante. O Google lançou um conjunto de videoclipes (acima) de seu mais recente gerador de vídeo Veo 2 esta semana e, na maior parte, é muito difícil dizer que os clipes não foram feitos por mãos humanas. O Veo 2 aparentemente tem uma compreensão melhor de coisas como anatomia e física do que o Veo original, o que permite criar clipes com significativamente menos problemas de IA e menos alucinações. Você pode se inscrever em uma lista de espera para experimentar o Veo 2 em labs.google/videofx.

Desenvolvimento mais recente

Google diz que Veo 2 AI pode gerar vídeos sem todas as alucinações

Cinco dedos por mão são um grande passo para a IA

O novo experimento Whisk do Google é uma ferramenta para brainstorming visual. O Whisk permite gerar imagens com base em uma “configuração”, “cena” e “estilo” definidos pelo usuário. Para cada aspecto, você pode fazer upload de uma imagem existente ou inserir um prompt de texto. Você também tem a opção de refinar as imagens de saída com solicitações adicionais. Os resultados geralmente não são de alta qualidade, mas o Google posiciona o Whisk mais como uma ferramenta de idealização do que como criação de imagens prontas para uso. Você pode experimentar o Whisk agora mesmo em labs.google/fx/tools/whisk.

História completa

O novo Whisk AI do Google permite inserir imagens como solicitações para criar novas imagens

A última criação do Google Labs é divertida

Os verificadores de fatos de Gêmeos estão supostamente avaliando assuntos que eles não conhecem. De acordo com relatórios do TechCrunch, os trabalhadores contratados que avaliam as respostas do Gemini não são mais capazes de ignorar as respostas que estão fora de sua compreensão, com a orientação do Google supostamente lendo, em parte, “Você não deve pular solicitações que exigem conhecimento de domínio especializado”. Isso é bastante preocupante! Lembre-se de verificar novamente as informações fornecidas pela IA antes de agir de acordo com elas.

Desenvolvimento mais recente

A nova política do Google instrui os verificadores de fatos da Gemini a agir fora de sua experiência

O Google pode minar suas reivindicações de precisão