As estruturas de inteligência artificial (IA) e os chatbots de IA dependem fortemente do aprendizado de máquina. O aprendizado de máquina usa fórmulas matemáticas e conjuntos de dados para aprender novas informações com supervisão mínima ou nenhuma. Um mecanismo de ponte traduz então os dados em interações contextualizadas. É aqui que entra em jogo a aprendizagem reforçada a partir do feedback humano (RLHF).

O que é treinamento de feedback humano?

Algoritmos avançados desempenham um papel fundamental no ensino de grandes modelos de linguagem (LLMs) para conversar naturalmente com os usuários. Eles usam codificação para analisar padrões e identificar relacionamentos. Essa é uma tarefa baseada em lógica que qualquer banco de dados pode realizar. Não é uma maneira humana de pensar. O aprendizado de máquina (ML) por meio do aprendizado por reforço é mais eficaz no treinamento de LLMs para pensar e responder como humanos.

O que é aprendizado de máquina?

O processo pelo qual os computadores aprendem a prever tendências de ações

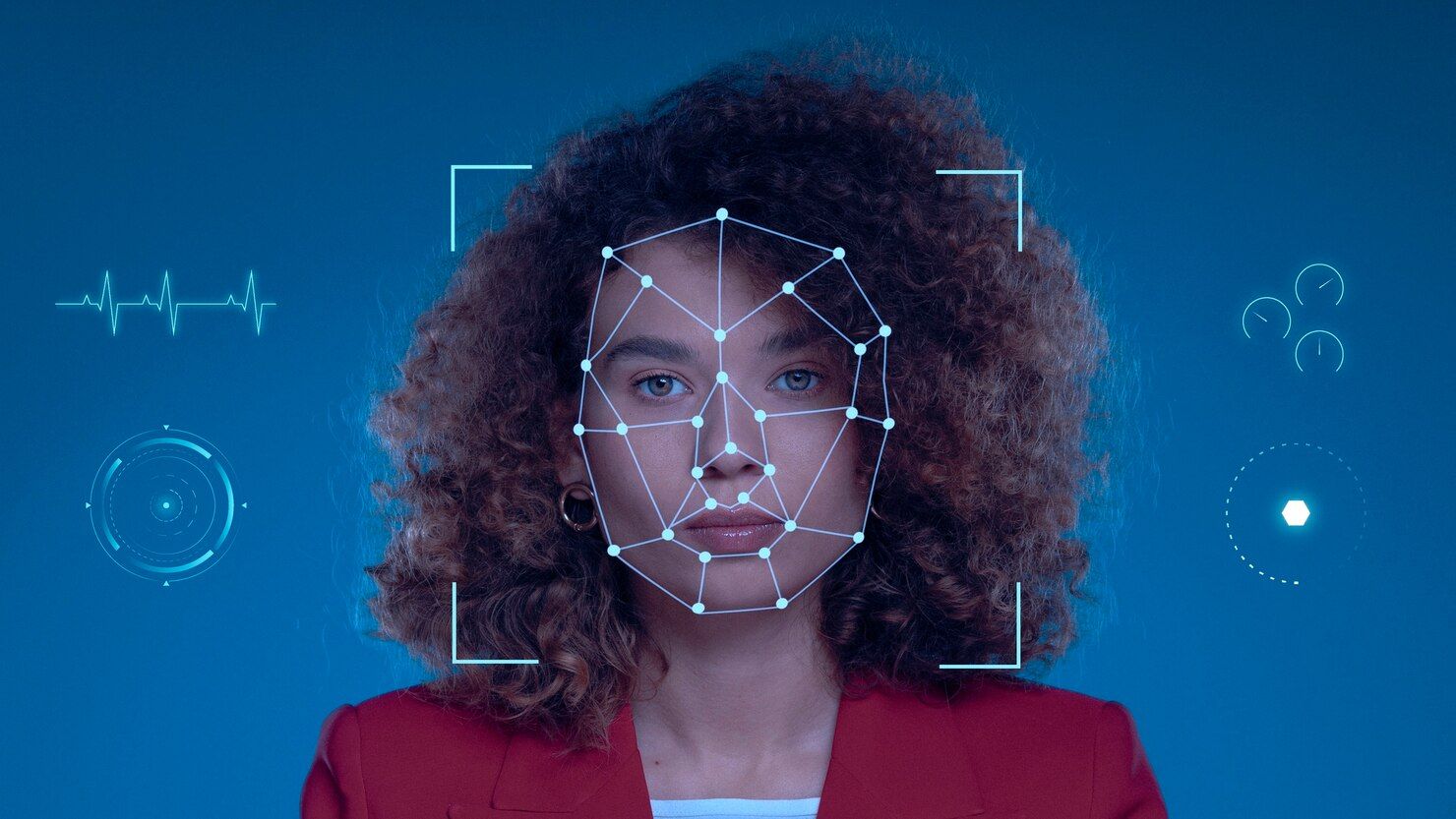

Além disso, é essencial ter discussões abertas em torno dos recursos de IA que imitam as características humanas, pois a falta de transparência pode levar à desconfiança e à suspeita entre o público. À medida que continuamos a incorporar capacidades semelhantes às humanas na tecnologia, as considerações éticas devem permanecer na vanguarda dos processos de desenvolvimento e implementação.

Pense em como um recém-nascido aprende a falar e a compreender a linguagem. Um bebê não sabe interpretar algoritmos complexos. Eles aprendem por tentativa e erro, com feedback constante dos pais ou responsáveis. Da mesma forma, a aprendizagem por reforço envolve feedback de humanos. Os LLMs, expostos a conversas reais, aprendem e melhoram suas respostas de maneira humana, por meio de tentativa e erro.

Fonte: Pexels

Como funciona o RLHF de tentativa e erro?

RLHF é outra palavra da moda em IA, como redes neurais e aprendizado de máquina. O que é aprendizagem reforçada e como ela transforma dados em interações significativas moldadas pelo feedback humano?

Digamos que as redes neurais tenham um intelecto infinitamente mais capaz. Eles são virtuais e compostos por bilhões de linhas de dados brutos, por isso precisam de mais informações. Existe um sistema de recompensa e penalidade, com um ciclo de feedback criado à medida que as respostas geram mais dados. À medida que o loop é executado continuamente, o processo de aprendizado de máquina ganha uma compreensão mais refinada do contexto de uma conversa.

Isso funciona para ciclos de feedback baseados em consultas e respostas, até conversas diferenciadas, que exigem um toque humano. Qualquer coisa menos do que isso faz com que a versão textual do “vale misterioso” seja sentida no lado humano, porque as respostas dos LLMs podem parecer quase humanas, mas ficam aquém da realidade. O loop RLHF é assim:

- O usuário humano faz uma consulta ou frase introdutória como uma declaração de entrada.

- Uma ação inicial é criada como resposta pela rede neural.

- Aqui está o ponto crucial do mecanismo de ciclo de feedback. O humano recebe a resposta e a avalia no contexto natural.

- Dependendo das aplicações do setor ou do cenário de uso específico do negócio, o ser humano é um membro experiente da empresa que pode preencher os prompts fornecidos com precisão e naturalidade.

- As respostas explícitas são feitas como pontuações ou talvez como um sinal de positivo, presumindo que o feedback seja positivo. Uma negativa, uma resposta negativa, é interpretada como uma penalidade.

- As respostas implícitas são um pouco mais complexas. À medida que uma conversa avança, os algoritmos observam o fluxo natural da conversa, atribuindo pontuações aos ramos conversacionais preferidos. As respostas sem saída são marcadas com pontuações negativas.

- Os pontos atribuídos às respostas geradas pela contribuição humana são utilizados para atualizar o modelo de linguagem e melhorar suas habilidades naturais de comunicação.

Este mecanismo de feedback humano é um loop em tempo real. Feedback positivo e negativo, recompensa e penalidade. Todos os dados moldam lentamente o modelo de linguagem, refinando-o e treinando-o para interagir naturalmente.

Por que o aprendizado por reforço é importante?

Não importa a especialidade de um modelo de linguagem, seu objetivo é imitar uma pessoa real. Isso pode ser visto nas funções do chatbot do ChatGPT. Após cada entrada, você verá um ícone de polegar para cima e um ícone de polegar para baixo. Duas caixas de diálogo aparecem quando você passa o mouse sobre elas. O ícone de polegar para cima indica uma resposta boa, enquanto o ícone de polegar para baixo é uma resposta ruim.

Este é um pequeno exemplo de RLHF explícito em ação. ChatGPT solicita mais informações quando sua resposta é penalizada com um polegar para baixo. Esteja preparado para digitar seus motivos para rejeitar sua saída.

É uma parte importante da experiência de aprendizagem. Os modelos de aprendizado de máquina coletam dados e empregam algoritmos, mas também codificam o feedback humano como meio de treinamento cognitivo. Na verdade, você está moldando a personalidade artificial de uma máquina e sua capacidade de linguagem natural. À medida que aprende, ele age de forma mais humana. O próximo usuário faz o mesmo para que as iterações contínuas do ciclo de feedback produzam um chatbot ou agente virtual que parece um indivíduo maduro, alguém que promove a confiança em uma marca, negócio ou presença de empresa.

Como o Transfer Learning melhora e diversifica os modelos de aprendizado de máquina

A transferência de aprendizagem em IA reflete a habilidade humana, usando o conhecimento de uma tarefa para avançar outras

A evolução da aprendizagem por reforço

Os modelos de aprendizado de máquina e os LLMs desenvolverão intelectos sobre-humanos devido às iterações contínuas do ciclo de feedback de recompensa-penalidade? Esse é um cenário improvável. Na verdade, os chatbots e agentes virtuais assumirão qualidades mais humanas, a não ser que desistam quando chegar às 17h.

Nenhum conjunto de dados extraído da Internet, nem interações humanas encontradas em um site de engenharia social, podem imitar os humanos, não sem uma certa quantidade de fala artificial e afetada que soa como o computador da nave estelar Enterprise. Para conversas naturais, o RLHF é a abordagem mais promissora.

Como se beneficiar do aprendizado de máquina e LLMs

De que outra forma os usuários podem obter um relacionamento satisfatório com as máquinas? Eles não conseguem sentir, não conseguem curtir música ou saborear comida. Estas são atividades humanas. O conhecimento dessas respostas biologicamente enraizadas está trancado dentro de um cérebro real. A única maneira de o aprendizado de máquina e a inteligência artificial adquirirem esse conhecimento e se tornarem sencientes é aprender com você.

Em vez de ser questionado por um robô, fornecer feedback em tempo real é mais agradável, o que é possível graças ao aprendizado por reforço. Com o aprendizado por reforço, as máquinas são ensinadas a aprimorar as conversas em linguagem natural.